논문 링크: https://arxiv.org/abs/1905.09263

FastSpeech: Fast, Robust and Controllable Text to Speech

Neural network based end-to-end text to speech (TTS) has significantly improved the quality of synthesized speech. Prominent methods (e.g., Tacotron 2) usually first generate mel-spectrogram from text, and then synthesize speech from the mel-spectrogram us

arxiv.org

1. 서론

1.1 논문 선정 이유

FastSpeech는 딥러닝 기반 음성 합성(Text-to-Speech, TTS) 모델로, 기존의 Autoregressive 방식의 TTS 모델이 가지는 느린 속도와 오류 전파 문제를 해결하기 위해 제안되었다. 본 논문 리뷰를 통해 FastSpeech의 핵심 아이디어, 실험 결과 및 한계점을 분석하고, 해당 연구가 TTS 분야에 미친 영향을 살펴보고자 한다.

2. 논문 요약

2.1 논문 제목 및 저자 정보

- 제목: FastSpeech: Fast, Robust and Controllable Text to Speech

- 저자: Yi Ren, Yangjun Ruan, Xu Tan, Tao Qin, Sheng Zhao, Zhou Zhao, Tie-Yan Liu

- 출처: NeurIPS 2019

2.2 연구 배경 및 목적

기존의 TTS 모델은 주로 Autoregressive 방식으로 동작하며, 이를 통해 자연스러운 음성을 합성할 수 있다. Autoregressive 방식은 이전의 출력을 다음 시퀀스의 input으로 사용하는데 이는 품질 저하와 결과 도출 속도가 느리다는 단점이 있다. 또한 구조상 오류가 축적될 수 있으며, 이를 제어하는 것이 쉽지가 않다.

이를 해결하기 위해 FastSpeech는 비자동회귀(Non-Autoregressive) 방식을 사용하여 빠르고 안정적인 음성 합성을 목표로 한다.

3. 핵심 내용 분석

3.1 방법론

FastSpeech는 Transformer 기반의 Non-Autoregressive TTS 모델로, 다음과 같은 핵심 아이디어를 포함한다.

- 길이 예측 모듈(Length Predictor): Autoregressive 방식에서 존재하는 디코더 스텝을 제거하고, 프레임 길이를 예측하여 병렬 합성을 가능하게 한다.

- Feed-Forward Transformer: 음성 합성에서 빠른 연산을 위해, 기존 Transformer를 수정하여 구조적으로 더 간단하고 효율적으로 설계하였다.

- 지속성 및 안정성 향상: 학습 과정에서 Teacher-Student 학습 방법을 활용하여, 빠르고 안정적인 음성 출력을 가능하게 한다.

FastSpeech 1의 모델 구조를 구성하는 주요 모듈은 다음과 같다.

The overall architecture for FastSpeech. (a). The feed-forward Transformer. (b). The feed-forward Transformer block. (c). The length regulator. (d). The duration predictor. MSE loss denotes the loss between predicted and extracted duration, which only exists in the training process.

(a) Feed-Forward Transformer (FFT)

Feed-Forward Transformer는 FastSpeech 1의 기본 구조이며, 텍스트 인코딩과 음향 특성 디코딩을 담당한다.

- Multi-Head Attention: 입력된 음소(Phoneme) 시퀀스에서 중요한 패턴을 학습하며, 서로 다른 위치 정보를 종합하는 역할을 한다.

- Add & Norm: Multi-Head Attention 출력을 원래 입력과 더한 후 정규화(Normalization)하여 안정적인 학습을 가능하게 한다.

- Conv1D: 1D 합성곱을 사용하여 국소적인 특징을 학습하며, 음소 간의 관계를 더욱 정밀하게 모델링한다.

(b) FFT Block

FFT Block은 여러 개의 Feed-Forward Transformer 레이어로 구성되며, 음소와 음향 특징 간의 변환을 수행한다.

- Duration Predictor: 각 음소의 지속 시간을 예측하여 발화 길이를 조절하는 역할을 한다.

- 𝛼 = 1.0: 길이 조정 인자로, 기본적으로 원래 예측된 길이를 그대로 사용한다.

- 𝒟 = [2,2,3,1]: FFT Block 내부의 레이어 구성을 나타내며, 여러 개의 블록을 통해 깊이 있는 특징 학습이 가능하다.

(c) Length Regulator

Length Regulator는 음소의 지속 시간을 조정하는 모듈이며, Autoregressive Transformer TTS에서 추출한 지속 시간 정보를 활용한다.

- Duration Extractor: Tacotron 2에서 사용한 Attention Alignment 정보를 기반으로 각 음소의 지속 시간을 추출한다.

- Conv1D + Norm: 지속 시간 정보를 학습하기 위해 1D 합성곱과 정규화를 적용한다.

- Linear Layer: 지속 시간을 예측한 후, 이를 음소 길이 조정에 활용하기 위해 변환하는 역할을 한다.

- MSE Loss: 예측된 지속 시간과 실제 지속 시간 간의 Mean Squared Error(MSE) 손실을 계산하여 모델을 학습한다.

(d) Duration Predictor

Duration Predictor는 각 음소의 지속 시간을 예측하는 모듈이다.

- Conv1D 기반의 신경망 구조를 사용하며, 입력된 음소 시퀀스를 기반으로 지속 시간을 추론한다.

- Tacotron 2의 Attention 기반 길이 예측 방식과 달리, 명확한 목표값(ground-truth duration)을 학습하는 방식이다.

- 예측된 지속 시간은 Length Regulator를 통해 조정된 후 음향 특성 변환 과정에 반영된다.

이러한 구조를 통해 FastSpeech 1은 Autoregressive 모델 대비 빠른 속도로 음성을 합성할 수 있으나, Prosody 조절이 제한적이며 음질 최적화가 어렵다는 단점이 존재한다.

3.2 실험 결과

MOS(Mean Opinion Score)는 음성 합성, 통신, 오디오 및 비디오 품질 평가에서 사용되는 주관적 품질 평가 지표이다. MOS는 평가자가 시스템에서 생성한 음성 또는 비디오의 품질을 1에서 5까지의 점수로 평가하도록 한다. 보통 여러 명의 평가자(사람)가 각 샘플을 평가한 후, 그들의 점수를 평균 내어 결과를 도출한다.

평점 기준은 일반적으로 다음과 같다.

- 5: 완벽한 품질 (완벽한 이해 가능성, 자연스러움)

- 4: 매우 좋음 (거의 완벽하지만 미세한 결점 있음)

- 3: 보통 (다소 부족하지만 수용 가능한 품질)

- 2: 나쁨 (일부 인식이 어려운 부분이 있음)

- 1: 매우 나쁨 (이해 불가능하거나 큰 결함이 있음)

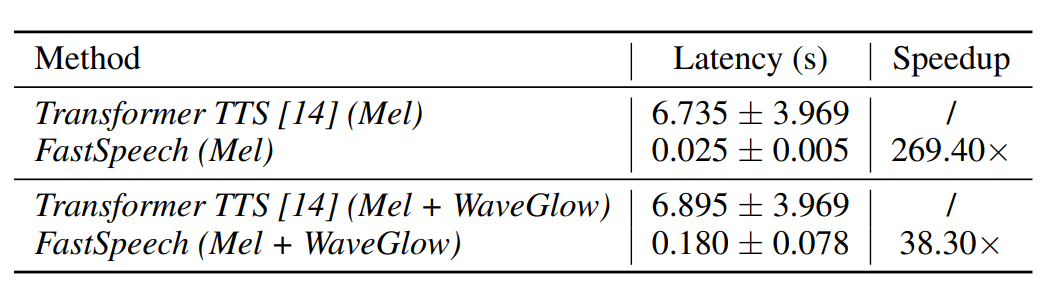

- MOS 평가에서 FastSpeech는 기존의 Autoregressive 모델과 유사한 수준의 음질을 유지한다.

- FastSpeech는 Autoregressive 방식의 TTS 모델(Tacotron 2)보다 10배 빠른 합성 속도를 보여준다.

- 길이 예측 모듈을 통한 비자동회귀 방식을 사용하여 inference 과정에서 발생하는 불안정성을 줄이는 데 성공하였다.

3.3 결론

FastSpeech는 비자동회귀 방식을 도입하여 TTS 모델의 속도와 안정성을 크게 개선하였다. 실험 결과에서도 기존 Autoregressive 모델과 비교하여 속도와 품질 측면에서 경쟁력 있는 성능을 보였다. 이는 실시간 음성 합성 시스템에 적용될 가능성을 높이는 중요한 연구 결과이다.

4. 장점과 한계

4.1 연구의 장점

- Autoregressive 방식보다 현저히 빠른 속도를 제공한다.

- Non-Autoregressive 구조로 인해 디코딩 시 오류 전파 문제가 발생하지 않는다.

- Transformer 기반 모델을 활용하여 학습 및 추론 안정성을 향상시켰다.

4.2 연구의 한계와 개선 가능성

- Non-Autoregressive 방식이지만, 길이 예측의 정확도에 따라 음질이 변할 가능성이 있다.

- FastSpeech 1에서는 음질이 Tacotron 2보다 다소 낮은 문제가 보고되었으며, 이를 해결하기 위해 후속 연구(FastSpeech 2)에서 변형이 이루어졌다.

- Prosody(억양 및 강세) 제어가 제한적이기 때문에, 보다 세밀한 음성 조절 기능이 추가될 필요가 있다.

5. 관련 연구 및 응용

5.1 관련 연구 비교

- Tacotron 2 (2018): Autoregressive 방식으로 자연스러운 음성 합성이 가능하지만 속도가 느리고, inference 과정에서 오류가 누적될 수 있다.

- WaveNet (2016): 음질이 뛰어나지만, 실시간 처리 속도가 느려 실용성이 낮다.

- FastSpeech 2 (2020): FastSpeech의 단점을 보완하여 더 자연스러운 음성을 생성할 수 있도록 개선되었다.

5.2 실질적 응용 가능성

- FastSpeech는 실시간 TTS 시스템에 적합하여 음성 비서, 내비게이션, 오디오북 등 다양한 서비스에 활용될 수 있다.

- Edge Device에서 효율적으로 동작할 수 있어, 모바일 기기나 IoT 환경에서도 사용될 가능성이 크다.

- 향후 감정 표현 및 억양 조절 기능이 강화된다면, 더욱 폭넓은 음성 합성 응용이 가능할 것으로 기대된다.

결론

FastSpeech는 기존 TTS 모델이 가진 속도 및 안정성 문제를 해결하며, Non-Autoregressive 방식의 가능성을 보여준 중요한 연구이다. 다만, 음질과 Prosody 조절 측면에서 추가적인 개선이 필요하며, 이를 해결하기 위한 후속 연구가 지속적으로 진행되고 있다. 향후 FastSpeech 기반 모델이 더 정교해진다면, 실시간 음성 합성 기술의 핵심 요소로 자리 잡을 것으로 예상된다.